9月4日「生成AI問題と著作権」勉強会報告(第2部)事前質問への一問一答

2025年9月4日、出版ネッツ主催の「生成AI問題と著作権」勉強会がオンラインにて開催された。

講師は、知的財産法・著作権法の専門家で、山形大学准教授の佐藤豊さん。

第1部は〈基礎知識のレクチャー〉、第2部は〈事前質問への一問一答〉、第3部は、〈被害事例〉と〈質疑応答〉で、ネッツ組合員と外部の方を合わせて約70人が参加。充実した内容の勉強会となった。

今回は、第2部について報告する。

第2部〈事前質問への一問一答〉

Q.AIの学習や生成をある程度制限できる制度設計の可能性についてうかがいます。ヨーロッパで導入されているようなオプトインやオプトアウトの仕組み、あるいは補償金のような制度が日本でも実現する可能性はあるのでしょうか?

A.制度上は、立法すればもちろん可能です。しかし、それが実際に政治的にどう受け入れられ、成立するかは別の問題です。

個人的には、こうした制度を導入する方が良いと考えています。権利者側が何らかのアクションを起こすことで、プラットフォーム側も歩み寄り、双方にとっての落としどころが見つかる可能性があるからです。新聞社とAI開発企業の例のように、問題提起がなされることで、対話と解決の道が開けることもあります。

※オプトイン:ユーザーに対しデータの利用承諾を求めること。オプトアウト:利用されたくないデータをユーザーが選べること。

Q.いわゆる「狙い撃ち」のような特定のクリエイターを対象とした学習、あるいは技術的保護手段を解除しての学習は、基本的に違法という認識で間違いないでしょうか?

A.はい、ご指摘の通りです。それらの行為は違法と判断される可能性が非常に高いです。

Q.著作権法第30条の4に定められている「著作権者の利益を不当に害すること」や「享受目的」といった要件の線引きが非常に難しいと感じます。これらを判断する上での「コツ」のようなものはありますか?

A.まず、この「著作権者の利益を不当に害する」という要件自体が、立場によって解釈が変わりやすいため、法的に機能しにくいのではないかという指摘もあります。

しかし、明らかに「黒」と判断されるケースは存在します。例えば、技術的保護手段を迂回して学習した、そして学習データと同様のデータベースがすでに有償で提供されている、といった場合です。これらは著作権者の利益を不当に害する可能性が高いと言えるでしょう。

Q.自分の作品が知らない間に学習されることによる精神的苦痛は、第30条の4の「不当に害する」に該当しますか? また、著作者人格権の侵害を主張することは可能でしょうか?

A.残念ながら、著作者の「精神的苦痛」というだけでは、第30条の4の「不当に害する」と解釈するのは条文上難しいでしょう。この条文は「著作権者」の経済的利益を保護するものであり、著作者個人の感情は直接の対象ではありません。

ただし、著作者人格権の侵害として主張できる可能性はあります。例えば、ディープフェイクによって本人が描いていない作品を本人の作品であるかのように見せかけられた場合、クレジットを偽られる氏名表示権の侵害などを問い、差し止めや慰謝料を請求できる途は残されています。

Q.出版社との契約で「著作者人格権の不行使」という特約を結んでしまった場合、クリエイターはAIによる二次利用に対して何もできなくなるのでしょうか?

A.これは非常に難しい問題ですが、いくつか対抗策は考えられます。

契約の有効性を問う:契約締結時に、クリエイターと出版社の間にあまりにも大きな交渉力の差があった場合、契約自体の有効性を争うことができるかもしれません。

不行使特約の範囲を限定的に解釈する:たとえ不行使特約があったとしても、著作者の名誉や社会的な評価を著しく傷つけるような利用(みなし侵害)まで許容したとは言えない、と主張する余地があります。

第三者による利用には直接対抗:不行使契約の相手はあくまで出版社です。契約とは無関係の第三者が無断でAIを使い作品を利用した場合は、著作者自身が直接権利を行使して差し止めることができます。

Q.例えば中国のようにAI開発に厳しい法律がある国で開発されたAIであっても、日本国内で利用された場合は日本の法律が適用されるのでしょうか?

A.はい、その通りです。日本の裁判例では、たとえ学習やモデル開発が海外で行われ、サーバーが海外にあったとしても、日本国内のユーザーがアクセスし、生成された結果を日本国内で受け取った場合(例:PCへのダウンロード、日本語サイトへの掲載など)は、日本の著作権法が適用されます。したがって、日本の法律に基づいて差し止めなどを求めていくことになります。

Q.クリエイターが自身の作品を守るために、現時点で取れる具体的な措置として事前告知、ウォーターマーク、自身でのデータセット販売などは有効ですか?

A.それぞれに限界と可能性があります。

事前告知(「AI学習禁止」など):残念ながら、日本の現行法では告知したからといって学習を直ちに止めさせる法的な強制力は限定的です。ただし、オプトアウトが認められているEU加盟国で学習を行う事業者に対しては、有効な場合があります。

ウォーターマークや保護フィルター:これらは技術的な対策であり、その有効性については技術の専門家にご相談いただくのが最善です。

Image-to-Image技術への対処:元の作品の特徴が強く残る形で利用された場合、「享受目的」と見なされ、著作権侵害を問いやすくなる可能性があります。

自身での学習用データセット作成・販売:これは非常に興味深く、有効な手段になり得ます。自身の作品を整理して「データベースの著作物」として加工し、それを有償で販売するのです。そうすれば、そのデータベースを無断でAIに学習させる行為は、「著作権者の利益を不当に害する場合」に該当する可能性が非常に高くなり、差し止めを主張しやすくなります。

その他の論点(テキスト系AI、声の権利、法改正など)

Q.テキスト系AI、AI生成物と二次創作の関係、産業翻訳、そして著作物ではない「声」の保護など、多岐にわたる質問について見解をお聞かせください。また、おすすめの専門書があれば教えてください。

A.それぞれお答えします。

テキスト系AIは問題ないか?:問題ないわけではありません。画像に比べて侵害の事実が発覚しにくいだけで、文章であっても著作権侵害は成立します。

AI生成物は二次創作と同じか?:ケースバイケースです。人間が創作的に関与し、具体的に指示して生成したものは、その人間を著作者とする二次的著作物になり得ます。一方、AIが自律的に生成したものは、現在の通説では「著作物ではない」とされています。

産業翻訳のAI利用:特許書類など、誰が翻訳しても同じような表現にならざるを得ないものは、そもそも著作物性が認められにくく、著作権法での保護は難しいのが現状です。

「声」の保護:「声」自体は著作物ではありませんが、俳優や声優の演技は「実演」として著作隣接権で保護されます。しかし、この権利は元の録音物の物理的なコピー(ルート)が対象であり、AIが生成した新たな声には及びにくいのが課題です。そのため、現在はパブリシティ権(人の氏名や肖像などが持つ顧客誘引力を保護する権利)を「声」にも拡張して適用する考え方が有力視されています。

法改正の方向性:著作権法を改正すべきか、あるいは新しい法律を作るべきかについては、まさに現在議論されている最中であり、政治的な判断も絡むため、現時点で見通すことは困難です。

おすすめの書籍

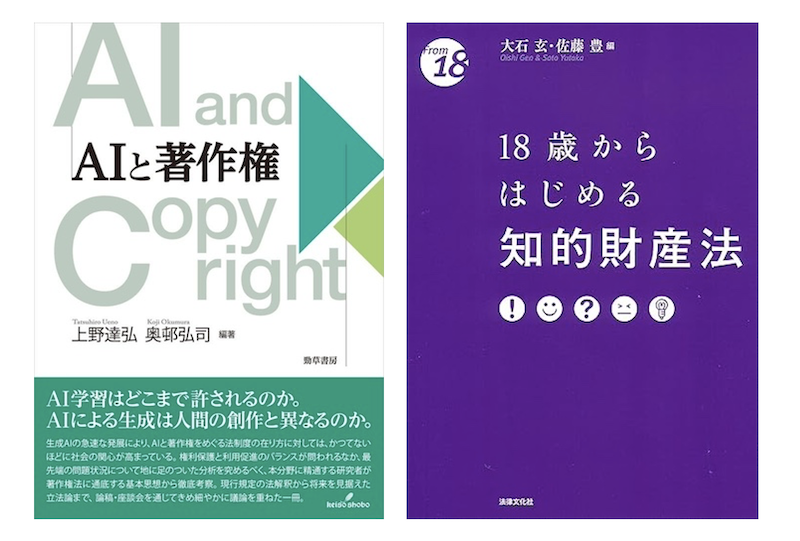

専門書:上野達弘先生と奥邨弘司先生が編集された『AIと著作権』(勁草書房、2024)が、この分野の議論を深く掘り下げており決定版と言えます。

入門書:少し宣伝になりますが、私が、富山県立大学の大石玄先生と共同で編集した、『18歳からはじめる知的財産法』(法律文化社、第2版、2025年)という本がこの10月に刊行され、AIに関する解説もあります。より平易な解説を求める方にはこちらがおすすめです。

(まとめ:生成AI勉強会プロジェクトチーム)

第1部-1〈基礎知識のレクチャー〉前編はこちら

第1部-2〈基礎知識のレクチャー〉後編はこちら

第3部〈被害事例〉と〈質疑応答〉はこちら